機械学習

機械学習 確率的勾配降下法(SGD)

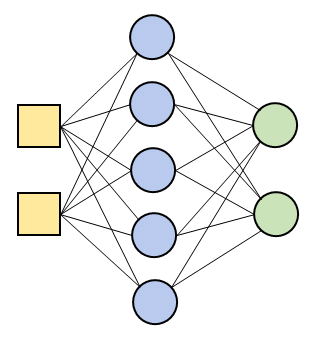

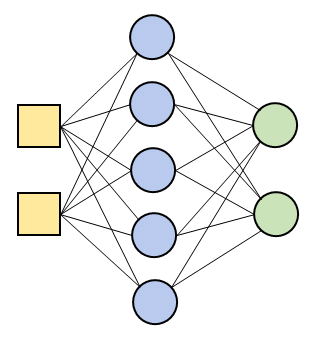

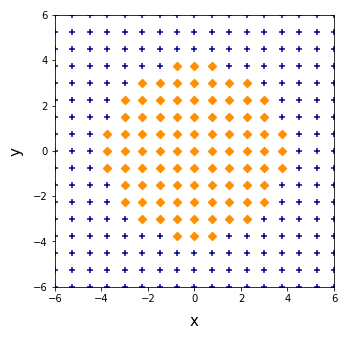

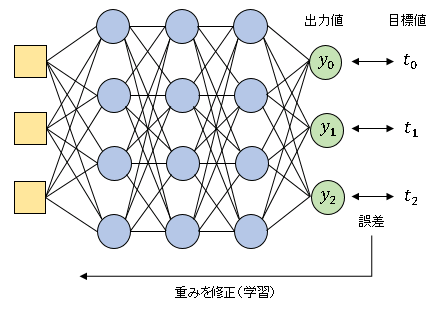

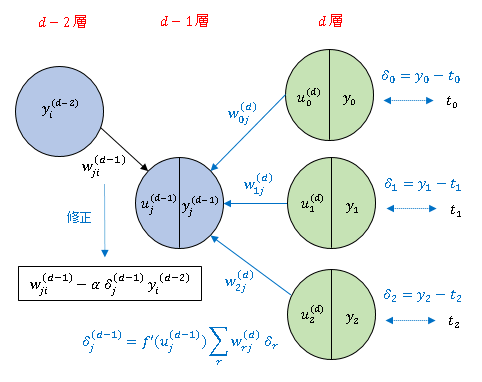

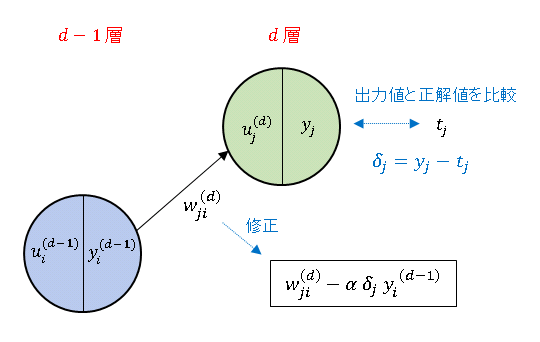

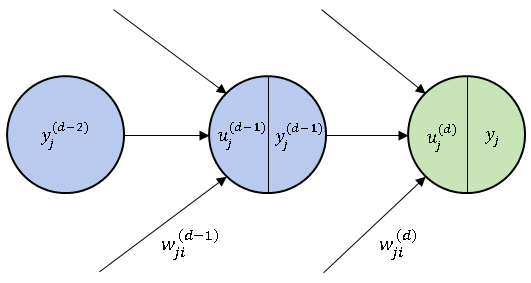

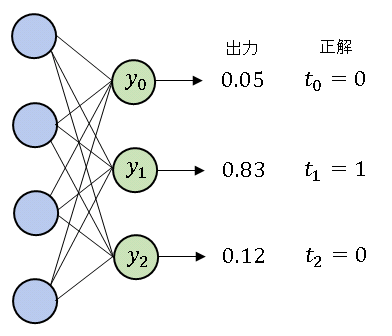

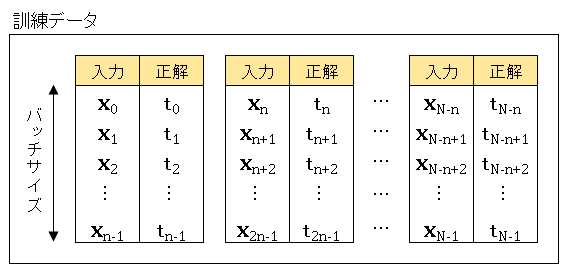

≪【前の記事】学習用データの作成 確率的勾配降下法(SGD)下図のように、入力層、中間層、出力層がそれぞれ 1 層ずつからなるニューラルネットワークを構築します。 中間層の活性化関数は ReLU を採用します。 すでに部品は揃っているので、...

機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  Python数学

Python数学  機械学習

機械学習  Python数学

Python数学  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習