機械学習

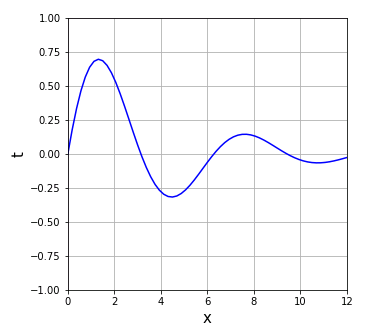

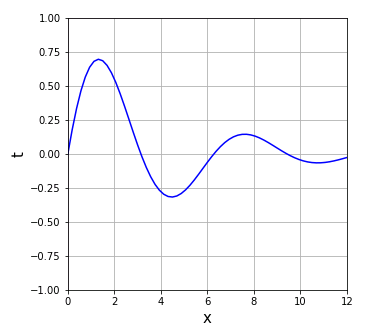

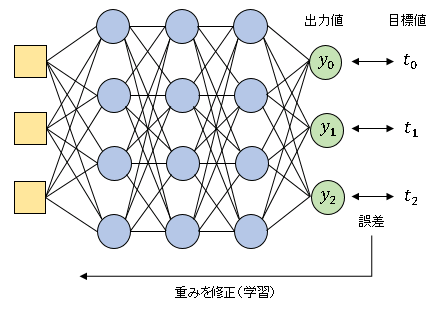

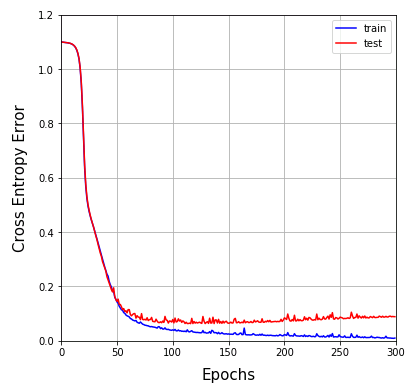

機械学習 減衰振動曲線の学習

≪【前の記事】ニューラルネットワークによる回帰分析 減衰振動曲線の学習Output_layer_cクラスを少し改造して Output_layer クラスを設計し、他の必要なコードもまとめて以下のリストに載せておきます。 # In # モジュ...

機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習  機械学習

機械学習